Azure Data Explorer ve Fabric ile Veri Analizi

Sistemlerden elde edilen log verileri, operasyonların izlenmesi, güvenlik denetimleri ve performans analizleri gibi birçok alanda kritik rol oynamaktadır. Bu verilerin merkezi bir yapıda toplanması, işlenmesi ve görselleştirilmesi, karar alma süreçlerine doğrudan katkı sağlar.

Microsoft’un sunduğu Azure Fabric Workspace ve Lakehouse mimarisi, bu ihtiyaca yönelik güçlü bir çözüm sunmaktadır. Lakehouse yapısı, verilerinin yapılandırılmış biçimde saklanmasını ve Power BI gibi araçlarla kolayca analiz edilebilmesini mümkündür.

Bu makalede, Azure Data Explorer üzerinde bulunan veritabanımdaki verileri Fabric Workspace’e nasıl aktarıldığı, Lakehouse üzerinde nasıl işlendiği ve bu verilerle Power BI dashboard’larının nasıl oluşturulduğu adım adım göstermeyi amaçladım.

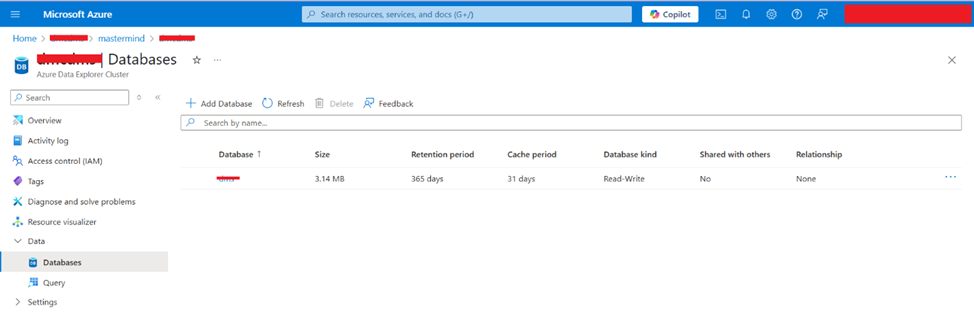

Bu uygulamada Resim1’de Azure Data Explorer üzerinde bulunan veritabanımdaki log verilerini analiz etmek istiyorum. Bunun için Microsoft Fabric Workspace ortamını kullanacağım. Veriyi önce Lakehouse yapısına alarak, ardından Power BI ile görselleştirerek dashboard oluşturacağız.

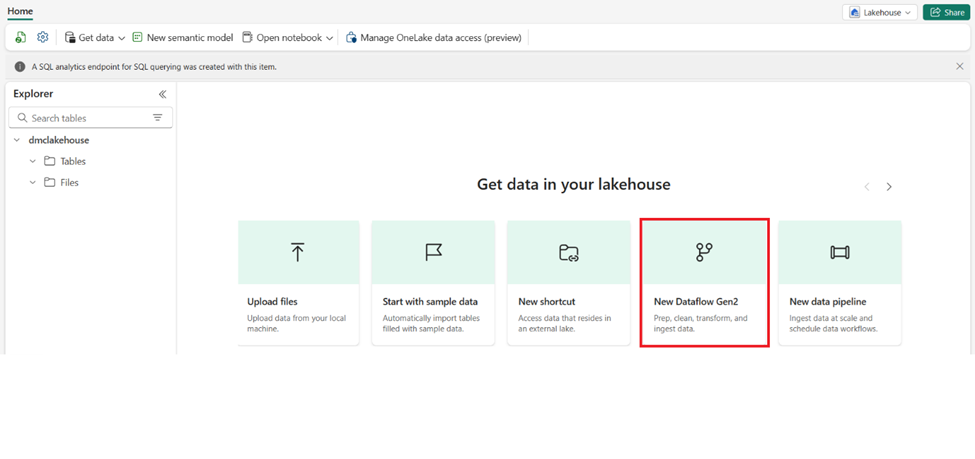

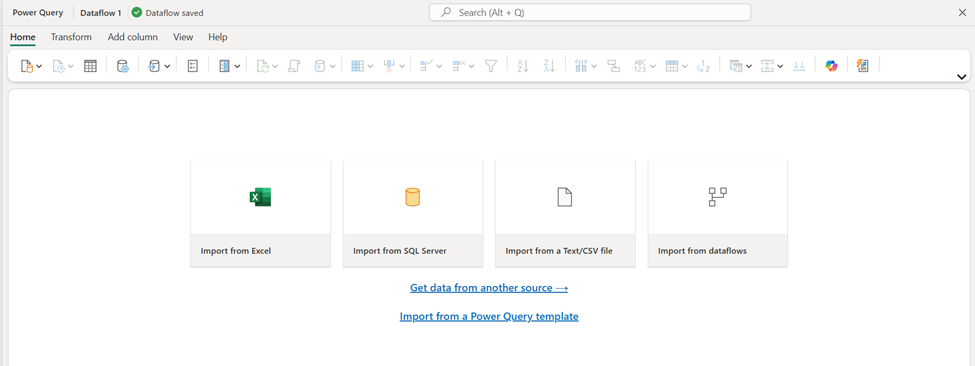

Veritabanından veriyi çekmek için Dataflow Gen2 kullanacağım. Bu sayede log verileri Lakehouse içinde Delta formatında saklanacak. Gerekirse burada bazı temizlik ve dönüştürme işlemleri yapacağım.

Son aşamada, Power BI’ı kullanarak Lakehouse’taki veriye bağlanacağım ve bu verilerle analiz ekranları oluşturacağım. Hedefim, log verilerinin durumunu anlık olarak takip edebileceğim interaktif bir dashboard hazırlamak.

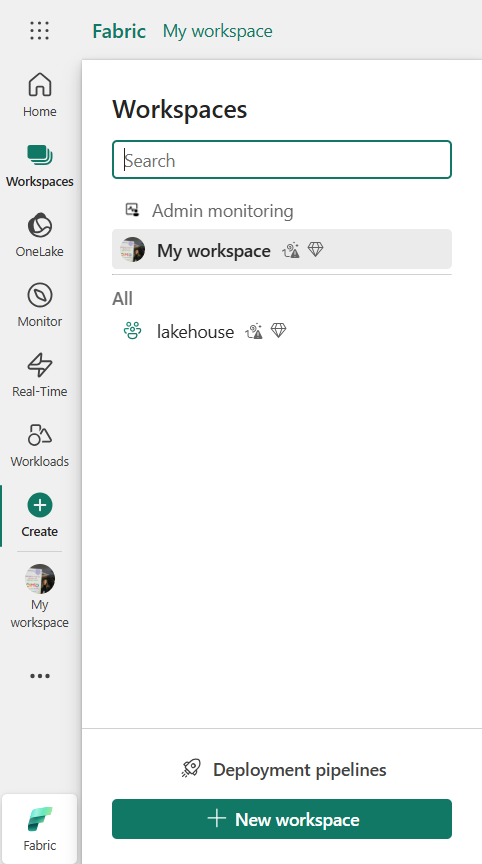

1-İlk olarak https://app.powerbi.com/ Microsoft Fabric portalında bir workspace oluşturdum. Bu workspace içinde hem Lakehouse’u hem de Power BI raporlarını barındıracağım.

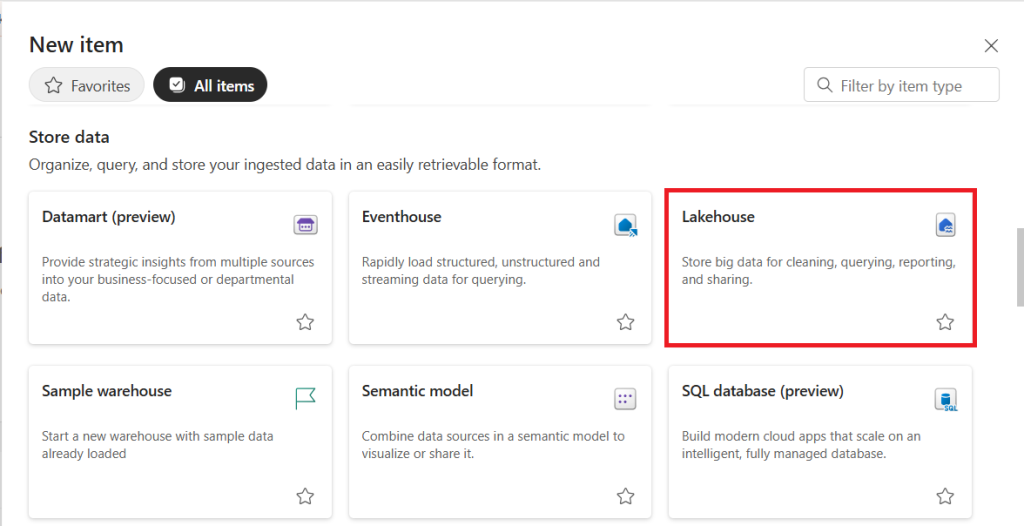

2-Workspace içinde bir Lakehouse oluşturuyorum. Bu yapı, verileri Delta formatında tutmamı ve analiz etmeye uygun hâle getirmemi sağlıyor. New item içerisinden Lakehouse oluşturuyoruz.

3-Azure Data Explorer veritabanımdan verilerini çekmek için iki yolum var:

- Dataflow Gen2: Veritabanına bağlanıp sorgu yazarak veriyi alabiliyorum.

- Notebook: PySpark kodu yazarak SQL’e bağlanıp veri çekebiliyorum.

Ben Dataflow Gen2 kullanarak tablolarımı alıyorum.

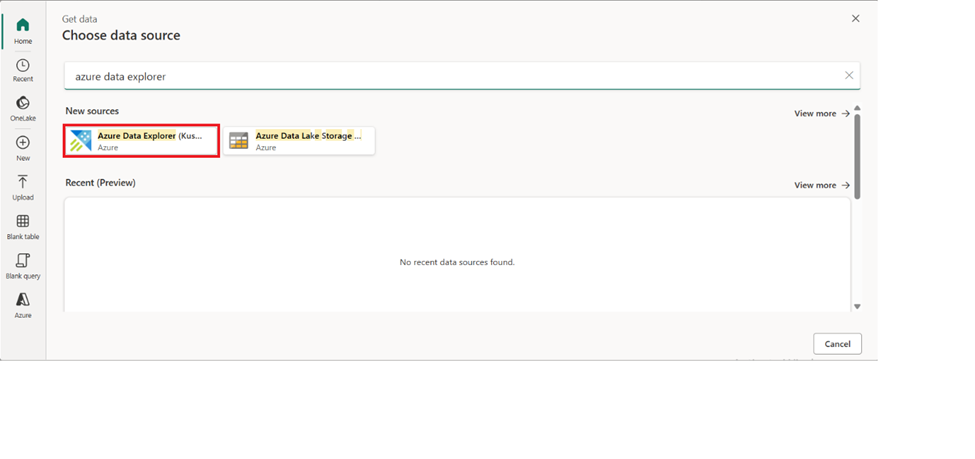

4-Get data from another source seçeneğine tıklayarak açılan pencere üzerinde Azure Data Explorer seçeneğini seçerek bağlantı sağlamamız gerekmektedir.

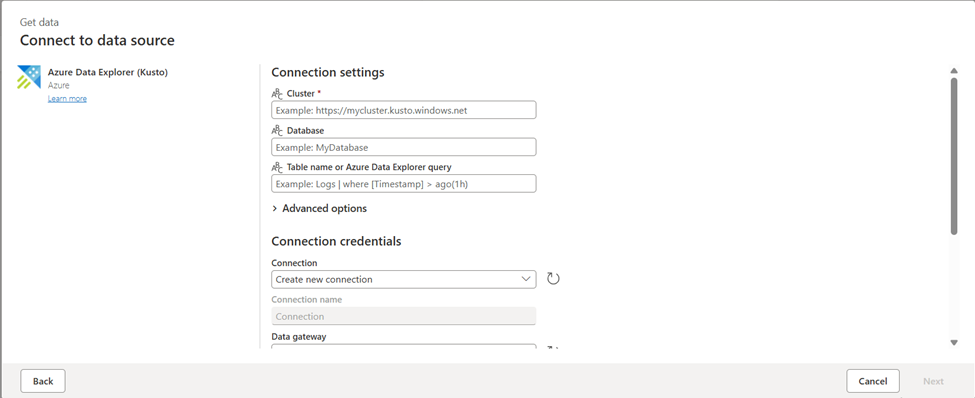

5-Açılan Connect to data source alanında gerekli yerleri doğru şekilde doldurarak bağlantı sağlıyoruz, devamında belirttiğimiz database’in içerisinden istediğimiz tabloları seçerek create ediyoruz.

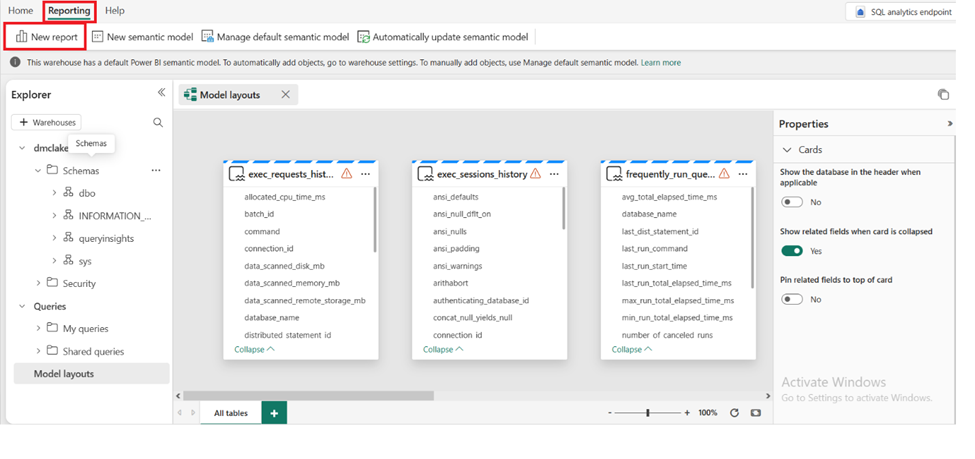

6-LakeHouse içerisinde açılan tablolarımızı artık görselleştirmey geçebiliriz. Lakehouse içerisinde Reporting ve devamında New report seçeneğine tıkladığımızda Power BI dashboard ekranı açılmaktadır.

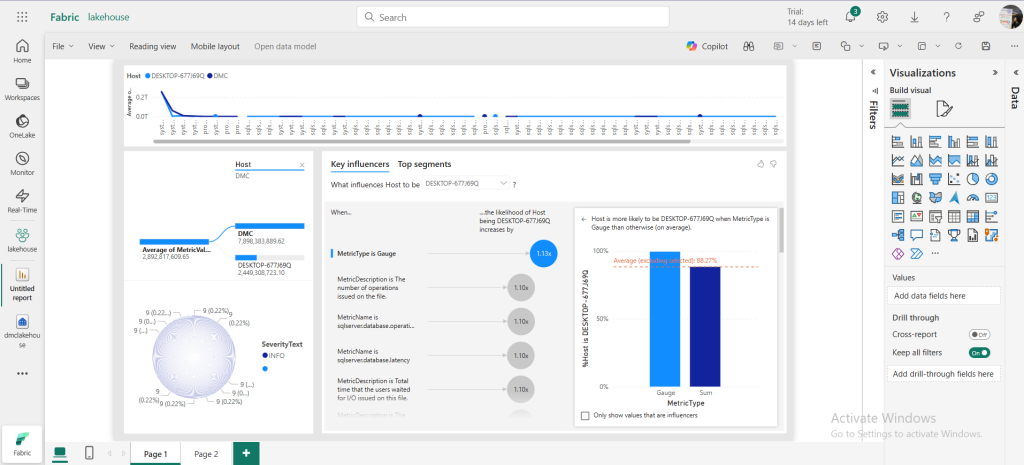

Resim9’ da, Azure Data Explorer’da bulundurduğum verilerle hazırladığım Power BI dashboard ekranı yer almaktadır. Ancak bu yazıda asıl vurgulamak istediğim nokta, Microsoft Fabric uygulamasının veri işleme ve görselleştirme süreçlerini tek bir platformda birleştirerek veriyle çalışan profesyonellere büyük kolaylık sağlamasıdır.

Azure Data Explorer’da bulunan verilerimizi Fabric içindeki Lakehouse yapısına aktararak, burada herhangi bir ek entegrasyon veya dış araca ihtiyaç duymadan hem veri dönüşümünü gerçekleştirdim hem de Power BI ile analiz ekranlarını doğrudan oluşturabildim. Bu yapı, özellikle kurumsal ölçekte çalışan ekipler için zaman kazandıran, sade ve entegre bir çözüm sunmaktadır.

Kaynak

https://learn.microsoft.com/en-us/fabric/fundamentals/microsoft-fabric-overview

https://learn.microsoft.com/tr-tr/azure/databricks/lakehouse